fluter, the magazine of the Bundeszentrale für politische Bildung publishes an article by our research associate Ariana Dongus on the deployment of face recognition in everyday life.

Gesichtserkennung ist längst Realität. Warum das gefährlich werden kann, zeigt schon ein Flug von Berlin nach London

Berlin-Tegel: Ich will nach London fliegen und warte an einer dieser Selbstbedienungsgrenzen, bei denen nicht mehr ein Beamter, sondern eine Maschine meinen Reisepass prüft. Sie trägt den Namen EasyPASS, trotzdem wird die Schlange immer länger. Endlich bin ich dran und lege meinen elektronischen Reisepass auf das Lesegerät.

Biometrische Daten werden heute systematisch genutzt, um die Identität einer Person zu ermitteln oder zu überprüfen. Was lange der Fingerabdruck war, sind heute Gesicht oder Iris. So werden auch meine Daten gerade ausgelesen, Name und Staatszugehörigkeit mit einer Datenbank abgeglichen. Nur: Das ist nicht alles. Mein digitales Ich passiert auch eine polizeiliche Datenbank. Das EU-Parlament hat kürzlich die Zusammenführung von sechs Datenbanken beschlossen, um biometrische Informationen über die aktenkundige Bevölkerung sowie Ein- und Ausreisende der EU zu bündeln.

Nur bedeutet „aktenkundig“ meist: auf der Flucht vor Krieg oder Verfolgung. Im Schengener Informationssystem, der größten der sechs Datenbanken, sind überwiegend Asylsuchende registriert. Offiziell wird die Zusammenlegung mit dem Hashtag #SecurityEU angepriesen – als „Sicherheitsdatenbank“ gegen Terror und Kriminalität. Mit ihr rücken Kriminalität und Flucht allerdings nicht nur in der Wahrnehmung mancher EU-Bürger*innen, sondern auch statistisch dicht zusammen.

Weiße, männliche Algorithmen?

Das zeigt, dass Datenbanken und Algorithmen nicht objektiv sind: Die Menschen, die an den Technologien basteln, sind überwiegend weiß und männlich, ihre Vorannahmen spiegeln sich in der Technologie. So wird künstliche Intelligenz manchmal zur künstlichen Dummheit oder gibt gar altbekannten Feindseligkeiten einen neuen Ausdruck.

Kürzlich warb beispielsweise ein Hersteller damit, dass seine Kamera Uiguren erkenne, eine verfolgte muslimische Minderheit, die die chinesische Regierung gerade zu Hunderttausenden in Lagern gefangen hält. Andere Softwares verwechseln People of Colour mit Gorillas, lassen „smarte“ Seifenspender nur auf weiße Hände reagieren oder sollen die sexuelle Orientierung am Gesicht ablesen. Dieser „Gaydar“ wäre nichts anderes als eine maschinelle Wiederbelebung der Phrenologie, an der schon die Nazis Gefallen fanden. Diese Pseudowissenschaft fußte auf der Vorstellung, dass man Persönlichkeit oder Intelligenz anatomisch, etwa an der Größe oder Form des Schädels, abmessen könne.

Die Klassifizierungen, die Maschinen bereits heute für uns treffen, sind für diejenigen, die sie nicht programmiert haben, oft schwerer zu erkennen. Algorithmen entscheiden über Kreditwürdigkeit und Jobchancen, prognostizieren Wahlverhalten, Sterbe- und Kriminalitätsraten. Nun wurde jemand aus der falschen Familie oder einem windigen Viertel immer schon schneller verdächtigt. Die Technologie entzieht bekannte (menschengemachte) Diskriminierungen aber dem Urteil: Ob ich einen Kredit bekomme oder von der Polizei aus dem Verkehr gezogen werde, hat schließlich ein vermeintlich unparteiischer Algorithmus entschieden. Einem Grenzbeamten kann ich Racial Profiling vorwerfen, bei solchen „Selbstbedienungsgrenzen“ wie hier in Tegel ist das schwer.

Hinter der Schranke: Ich zwänge mich zwischen zwei Plexiglastüren in die Schleuse des Automaten. Auf dem hellweißen Bildschirm erscheint ein Livefoto meines Gesichts. Vor meinen Augen: eine Emoji-Sonnenbrille.

Gamifizierung pur. Von den Operationen im Hintergrund – dem Abgleich der Livedaten mit meinem Pass und einer tendenziell problematischen Datenbank – bekomme ich nichts mit. Mein Gesicht wird zum Reisepass. Und eine Grenze nicht mehr durch Zäune oder Polizisten markiert, sondern durch Daten und Algorithmen automatisiert.

Die europäische Sicherheitsforschung arbeitet längst nicht mehr nur an der Identifizierung von Individuen, sondern auch daran, unsere Emotionen zu tracken: Eine Art Lügendetektor könnte bald erkennen helfen, ob man ein Land mit falschen Absichten betritt. Der Prozess dahinter heißt Affective Computing, das als verheißungsvolle Zukunftsindustrie gehandelt wird. Das Start-up Affectiva verkauft bereits Software, die aus Video- und Sprachmitschnitten Emotionen lesen und vorhersehen können soll.

Nach einigen Sekunden: ein grüner Pfeil, die Schleuse öffnet sich, ich habe die Grenze passiert. Ich setze mich vor mein Gate und versuche, die Gesichtserkennung auf meinem neuen iPhonezu aktivieren. Erfolglos.

Damit mich das Gerät als Besitzerin anerkennt, muss Face ID durch verschiedene Posen und Gesichtsausdrücke erst „angelernt“ werden. Das trainiert das Gesichtserkennungsverfahren, das Apple genauso nutzt wie Instagram, Facebook oder die umstrittene FaceApp. Um Software zur Gesichtserkennung zu entwickeln, brauchen Hersteller massenhaft Gesichter. Die Ergebnisse werden besser, je größer und vielseitiger das Trainingsset ist. Mein Kollege Adam Harvey hat aufgedeckt, wie Menschen deshalb auch ohne iPhone und Zustimmung in Gesichtsdatenbanken geraten können: Weil ungestellte Bilder, sogenannte data in the wild, besonders nützlich sind, wurden Kameraaufnahmen aus einem Café in San Francisco öffentlich als Testdaten angeboten.

Unsere Demokratien sind anfälliger für digitale Überwachung als wir meinen

Aus reiner Benutzerfreundlichkeit scheint Apple die Face ID also nicht anzubieten: Die erhobenen Daten werden zu Werbe- und Entwicklungszwecken genutzt, auch den Verkauf der erhobenen Gesichtsdaten zog Apple schon in Erwägung. Mit meinem Gesicht kann ich mein iPhone entsperren oder eine App kaufen, wenn ich das möchte. Tauchen diese biometrischen Daten aber andernorts und ohne mein Wissen auf, um mich auf anderem Videomaterial oder im öffentlichen Raum zu erkennen, kann ich mich nicht mehr entziehen.

Wie problematisch das werden kann, zeigten unter anderem die Ermittlungen zu den G20-Protesten 2017: Zur Identifizierung mutmaßlicher linksradikaler Straftäter*innen speiste die Hamburger Polizei ihre Gesichtserkennungssoftware auch mit knapp zehn Terabyte „polizeifremden“ Aufnahmen. Also Bild- und Videomaterial, das aus der Bevölkerung zur Verfügung gestellt worden war.

Am Flughafen London-Heathrow: Ich nehme den Bus in Richtung Innenstadt.

London gilt als die Videoüberwachungshauptstadt Europas: Wer hier lebt, weiß, dass an fast jeder Ecke Kameras hängen. Wie die New York Times-Journalistin Kashmir Hill gerade enthüllte, können sich an Autokratien erinnernde Gesichtserkennungssystemeauch in Demokratien durchsetzen: Das Programm „Clearview“ kennt die Gesichter von Millionen Menschen. Die US-Polizei setzt sie bereits ein, das Unternehmen arbeitet den Recherchen zufolge auch mit privaten Unternehmen.

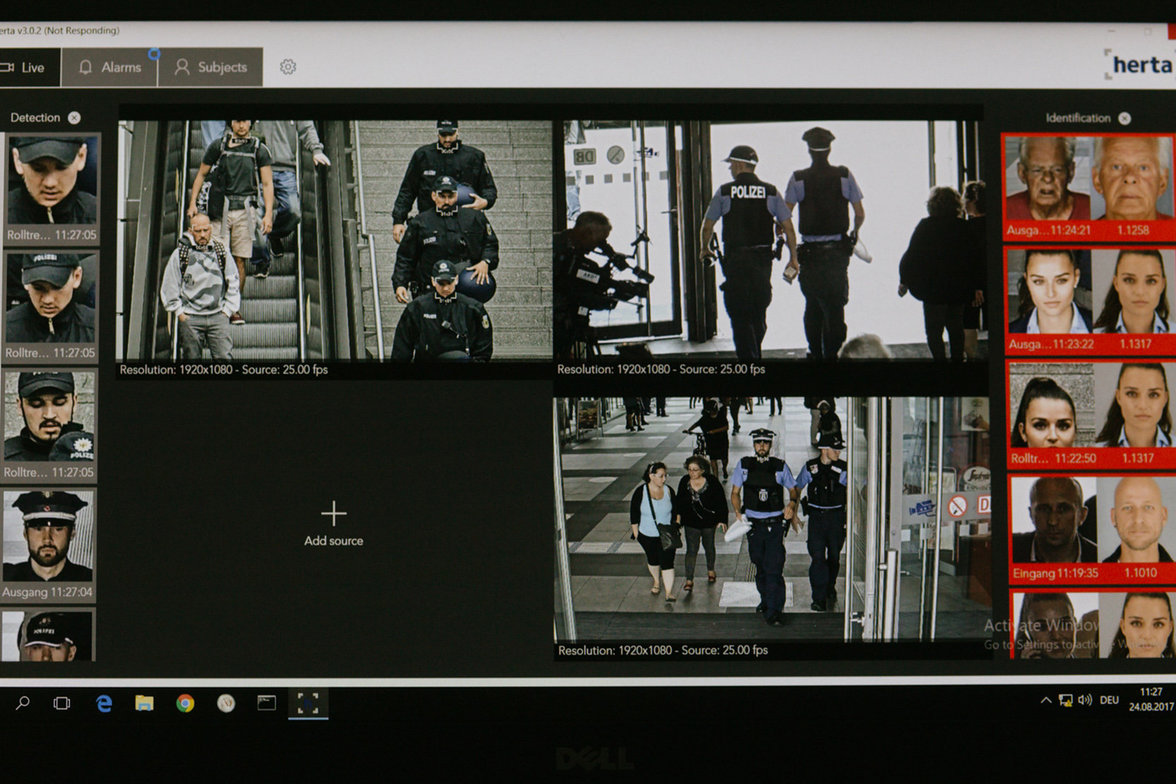

In Deutschland scheint diese Gefahr nicht zu bestehen: Die öffentliche Videoüberwachung wird vergleichsweise streng durch das Bundesdatenschutzgesetz reguliert, auch automatische Gesichtserkennung ist nicht erlaubt. Aber auch bei uns hängen Kameras an Bahnhöfen oder anderen öffentlichen Orten. Am Bahnhof Berlin-Südkreuz gab es mittlerweile schon zwei Pilotstudien, mit denen die Polizei das Erkennen von verdächtigen Situationen per intelligenter Videoüberwachung testet.

Die Serienmäßigkeit solcher Tests scheitert derzeit noch am Gesetz, heftigem Widerstand der Gesellschaft und der hohen Fehleranfälligkeit. Trotzdem können sie die Kameraüberwachung mit der Zeit normalisieren, entpolitisieren und indirekt unser Verhalten lenken. Denn allein der Gedanke, dass das eigene Verhalten verdächtig wirken könnte, kann einen nervös machen. Ob ich womöglich auffällig bin, weil ich Angst habe, auffällig zu sein? Das können Kameras und Software nicht sehen.

Ariana Dongus ist Dozentin für Medientheorie an der HfG Karlsruhe. Für ihre Promotion untersucht sie, wie sich biometrische Anwendungen auf die Gesellschaft auswirken.

Die Fotos sind von Nils Stelte. Das Titelbild zeigt eine Sicherheitsmesse in Essen (links) und den Protest gegen das erste Pilotprojekt am Bahnhof Südkreuz (rechts).